[月別過去ログ] 2015年12月

« 2015年11月 | 最新のページに戻る | 2016年01月 »2015年12月24日

■ 国際シンポジウム「哲学と経済学における意識と意図」でトークしてきた!

国際シンポジウム「哲学と経済学における意識と意図」(Consciousness and Intention in Economics and Philosophy)でキーノート・スピーカーとしてトークしてきた。(京都産業大学12/12-13)

オーガナイザーの方の「優しすぎるくらいでお願いします」というアドバイスを元にSDT解析部分を削ったのだけど、結果的に正解。途中質問ありで45分で講演してそこから15分くらい質問がずっと出続けだった。

会としてはこじんまりとしたもので朝一が30人、午後一の私のトークのときに40人くらい。経済心理学、実験経済学、哲学の人たちで構成されていて、懇親会でも哲学の人たちといろいろ話せてすごく良かった。

収穫だったのは実験哲学のShaun Nicholsがすごく興味持ってくれたところだろうか。氏の明日のトークの要旨を見てみたらhigh road/low road という二つのプロセスを考えていて、腹側、背側経路論と関連深そうだ。

Kurt Grayからは盲視との二重乖離の結果はないの?って質問があった。これはFAQだから「SC lesionはしてないけど、GoodaleのDFさんの話というのがあってactionのための視覚とperceptionのための視覚の二重乖離は示されている」と答えておいた。

あとShaun Nicholsからは「後半のサリエンシーの話で前半のyes-no課題の話は説明できるの?」って質問があった。これは東北大のトークのときの塩入先生からの質問に続いて二度目。塩入先生はこの仕事よくわかってくれてるから流石だなと思いながら答えたんだけど、Shaun Nicholsが初見でそこまで頭が回ることには驚いた。

答えとしては、forced-choice課題では二つの刺激条件のサリエンシーは全く同じで対称性がある。一方yes-no課題ではtarget条件と異なりno target条件ではサリエンシー検出器はなにもない画面から(ノイズを元にしてwinnner-take-allで)無理やりサリエンシーが高いところを作り出すだろうという点で、二つの刺激条件のサリエンシーは対称性がない。ここに違いがある。

塩入先生からはその説明で充分か?というツッコミをさらに受けたけど、今日の答えとしては二つの課題でのサリエンシーが違うというところまでは納得してもらえた様子。

あと、京産大の伊藤浩之さんとトークの後に雑談。サリエンシーでできることとそうでないことの切り分けの可能性としてbinding problemの話を提案してもらった。たしかに、いつもサリエンシーの話をする際にconjunction searchの絵を出したりしていたけど、そういう味方でbinding problemについて考えたことはなかった。(binding problem自体は偽問題だろ、みたいな議論があった頃から興味が薄れていた。)

でも、盲視でfeature間のbindingができるかどうかというとできたという話はないので、盲視ではかなりのことができてしまうのだけど(ポズナー課題で見えていない視野に注意を向けることさえできる!)、できないことのリストとしてbindingはあると言えそう。

もともと盲視の動物モデルを研究するにあたってひとつ考えていたことに「微小電気刺激などで失った意識経験を回復させる」というのがあったのだけれど、そうはいってもどうやって意識経験回復したか示せるのかよって問題があったのだけど、そこは置いた上で、feature blindingができるようにする、これ自体は十分可能で意義も大きいように思える。

忘れないうちにメモっておくと、yes-no課題でのno target条件では刺激がないのでどこにサリエンシーが高いかというと注視点が消失したところのサリエンシーが高いまま持続する。だからtarget条件も含めた行動選択としては、実際にターゲットがある場所と注視点のどちらかに行く。

つまり、ターゲットが出ていない反対側の選択肢の位置にサッカードする行動が非常に少ない(targetあり条件であってもおかしくないはずだがFC条件では<10%程度のみ見られる)のは、サリエンシーに基づいた行動選択を行っている証拠ではないかということ。

あと、motion saliencyへの反応を「もぞもぞしたかんじ」というのが触覚っぽくて面白いよねってのは参考になった。視覚入力が体性感覚野にrewiringした入力している可能性とか。

明日はShaun Nicholsのトークとあとひでまんのロボットへの社会認知のイメージングの話がメインイベントとなる予定。今日は疲れた!つかホテルに帰って爆睡して目覚めたら夜中の0時。これからどうしたものか。麦チョコ喰って考える。

京都駅へ向かう帰り道でドイツから来てた神経経済学やってるという人と語りながら帰ってきた。日本でハロウィーンが大人が仮装して馬鹿騒ぎするようになっている話をしたら驚いてた。ドイツでも10年くらいしたらそうなるかもねって言ってた。あと日本でもオクトーバーフェストやってるよってのも驚いてた。

へとへとになって家に帰ってきた。そのあとで京都がせっかくいい季節なのにどこも見てこなかったことに気がついた。といいたいところだけど始めっから気がついてた。京都大好き。

- / ツイートする

- / 投稿日: 2015年12月24日

- / カテゴリー: [視覚的意識 (visual awareness)]

- / Edit(管理者用)

2015年12月03日

■ Eye Tribe + Processingで視線位置のデータ収集してみた

以前のブログ記事でも書いたことがあるけど、Eye Tribeをいじってる。Eye TribeというのはUSB3で接続するポータブルなアイトラッカーのことで、アイトラッカーってのは人の視線がどこを向いているかを計測する機械。

たとえばこのアイトラッカーをパソコンの画面の下にくっつけておけば、使用者が画面上のどこを見ているかを調べることができる。だから広告業界とかにとっては重要なツールになる。もしくはマウスの代わりの入力デバイスとして使うこともできる。たとえばこの映像とか見るとゲームでの応用とかもできるのがわかるかと思う。

入力デバイスとしてのアイトラッカーのもう一つの重要な用途は、筋萎縮性側索硬化症(ALS)などで発話、キーボード入力などが出来ないような状況でも眼球運動は可能であるような場合で、この場合アイトラッカーが唯一可能なコミュニケーションデバイスとなる。しかしアイトラッカーというのは市販のもので数百万円するようなものなのでなかなか個人用で利用できるものでもなかった。

そこで廉価なデバイスとオープンソフトウェアとの組み合わせでアイトラッカーを自作しようというムーブメントが起きた。たとえばEYEWRITERではALSを発症したグラフィティアーティストTony Quanのために、プレーステーション用のカメラPlayStation EyeとC++用オープンソフトウェアopenframeworksを組み合わせることによって、視線入力によって再びグラフィティを作成することに成功している。入力デバイスとしての使用に関しては、日本語での資料としてはこちらがまとまっている:視線入力装置は自作できます。

このような状況に大きく風穴を開けたのがThe Eye Tribeというわけ。The Eye Tribeはこれまでの市販のアイトラッカーが数百万円という状況で、99ドルつまり1万円程度という廉価なアイトラッカーを出してきた。これまでのアイトラッカー(Tobiiとか)が専用のPCを使って計算をした結果をイーサネットなどで通信してデータ取得していたのに対して、The Eye TribeではUSB3接続で直で使用者のラップトップに接続できる。ゆえにポータブルにはなるけれども、多分あんまり複雑な計算はできていないはず。さてそれではどのくらいの精度が出るものか調べてみようというわけです。ということでやっと本題きた。(<-いつもよりちょっと丁寧な執筆をしております)

(私の研究での真の目的は、廉価なアイトラッカーを複数様々な位置に設置することでヘッドフリーでの広い視野角でのアイトラッキングが実現できるのではないか、というところ。今回はそのへんには立ち入らない。)

まあ論より証拠で、実際に計測した映像をアップロードしてみた。

この映像でやっているのはサッカード課題というもので、赤い丸が画面の中央に点灯して、それが左に移動して、真ん中に戻ってきて、右に移動して、また真ん中に戻ってくる。被験者の課題はこの赤い丸を追っかけてみるというもので、白い点がEye Tribeで計測した被験者の視線位置を表している。視線計測のフレームレートは30fpsで獲得して、実際の課題中にリアルタイムで自分がどこを見ているかモニターすることができている。

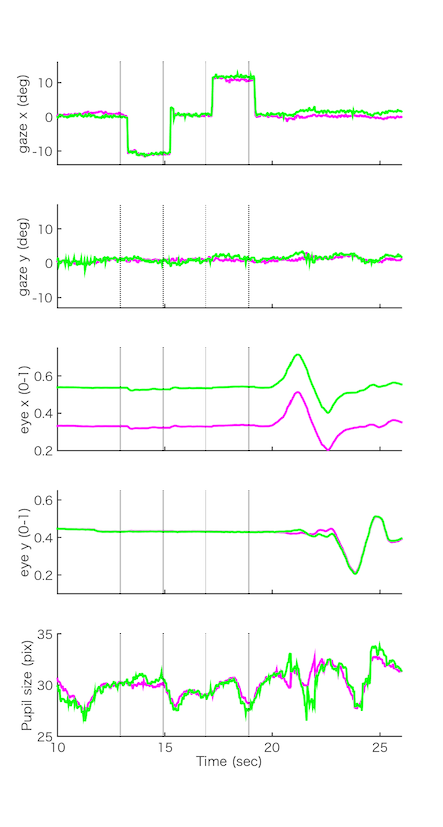

このときの計測データを横軸を時間にしてplotしたものがこちら。上からgaze(視線位置=眼球の動き)の(1)横方向の位置、(2)縦方向の位置、eye(眼球位置=頭部の動き)の(3)横方向の位置、(4)縦方向の位置、そして(5)瞳孔のサイズ。マゼンタが左眼、緑が右眼のデータ。Youtubeの動画では視線だけを動かしている10sec-22secあたりを切り出している。

眼球位置(3)(4)は安定して記録できてる。(3)を見ると左右の眼の間隔は一定なので20-23secあたりで左右に頭を動かしているときにこの間隔が変わらないことがわかる。(4)を見ると23-25secあたりに上下に頭を動かしているのがわかる。左右の眼は同じように動いている。

視線位置(1)(2)を見ると、横方向(1)に視線を移動させているのがわかる。縦線のある部分が赤点が移動したタイミング。こういう速い視線の動きのことをサッカードと呼ぶ。(<-やけに説明が親切) いっぽうで縦方向(2)には眼を動かしていないので変化はほとんど見られない。縦方向(2)のほうがノイジーなのがわかる。それでもばらつきは視野角にして1度くらいか。(真正面から真上までの視野角が90度だから、それの1/90、画面上だと27pixelに相当(測定時の画面からの距離に依存))

データ取得は30fpsなので眼球運動速度を計算するのはキビしいけど、それでもサッカードは検出できてる。マイクロサッカード(~0.5度くらいの小さいサッカード)を検出するのは無理そう。(The Eye Tribeは最大で60fpsで記録できるけど、ここでは安定性のため30fpsにしている。)

さてどうやって記録したかだけど、The Eye Tribe (99ドル)で記録したデータをオープンソフトウェアであるProcessingで表示している。Processingで視覚刺激の提示とThe EyeTribeから入力したデータの表示、記録を行っている。MacBook Air 11inchを使っているけど、Windows, Linuxでも同様な運用は可能。

The Eye Tribeが提供しているサーバプログラムを走らせると、JSON型式でのデータが30fpsで入ってくるので、それを扱えれば基本的にどんなプログラム言語でも処理可能。といいつつわたしはmatlabとpythonしか使えないので手をこまねいていたのだけど、processingでThe Eye Tribeのデータを読み込めるライブラリを作成してくれた人がいた:Processing用のEyeTribeライブラリをやっつけで作った

(ちなみに今ではほかにもProcessing3用のThe Eye TribeライブラリとしてEyeTribeProcessingというものある。こちらを使うとキャリブレーションのプログラムもProcessing上から動かすことが可能。)

このライブラリを使わせてもらって、この映像を作るためのprocessingのプログラムを書いた。ソースはgithubから入手可能なのでご自由に。(元のファイルを作成した方も「動作の保証もクレーム対応もしませんが、もしそれでもよければ使ってみてください」と書いてますので、それに準拠します。)

- / ツイートする

- / 投稿日: 2015年12月03日

- / カテゴリー: [上丘、FEFと眼球運動]

- / Edit(管理者用)

お勧めエントリ

- 細胞外電極はなにを見ているか(1) 20080727 (2) リニューアル版 20081107

- 総説 長期記憶の脳内メカニズム 20100909

- 駒場講義2013 「意識の科学的研究 - 盲視を起点に」20130626

- 駒場講義2012レジメ 意識と注意の脳内メカニズム(1) 注意 20121010 (2) 意識 20121011

- 視覚、注意、言語で3*2の背側、腹側経路説 20140119

- 脳科学辞典の項目書いた 「盲視」 20130407

- 脳科学辞典の項目書いた 「気づき」 20130228

- 脳科学辞典の項目書いた 「サリエンシー」 20121224

- 脳科学辞典の項目書いた 「マイクロサッケード」 20121227

- 盲視でおこる「なにかあるかんじ」 20110126

- DKL色空間についてまとめ 20090113

- 科学基礎論学会 秋の研究例会 ワークショップ「意識の神経科学と神経現象学」レジメ 20131102

- ギャラガー&ザハヴィ『現象学的な心』合評会レジメ 20130628

- Marrのrepresentationとprocessをベイトソン流に解釈する (1) 20100317 (2) 20100317

- 半側空間無視と同名半盲とは区別できるか?(1) 20080220 (2) 半側空間無視の原因部位は? 20080221

- MarrのVisionの最初と最後だけを読む 20071213